Rivoluzione in arrivo

Nvidia annuncia Blackwell, la nuova generazione di chip per l'intelligenza artificiale

Le prime unità verranno distribuite entro la fine dell'anno. Ancora sconosciuti i prezzi ma la potenza di calcolo è da urlo

di Stefano Silvestri 19 Marzo 2024 07:45

Dall'irruzione di ChatGPT di OpenAI sul palcoscenico digitale a fine 2022, che ha scatenato un fervore senza precedenti per l'intelligenza artificiale, il valore di mercato di Nvidia ha visto una crescita esponenziale, con un'impennata di cinque volte del prezzo delle sue azioni e di tre volte delle vendite globali. Le avanzatissime GPU di Nvidia si sono imposte come componenti irrinunciabili nella realizzazione e nel funzionamento dei modelli di intelligenza artificiale più avanzati. E grandi nomi del settore tecnologico, come Microsoft e Meta, hanno destinato miliardi di dollari all'acquisizione di questi preziosi (e introvabili) prodigi tecnologici.

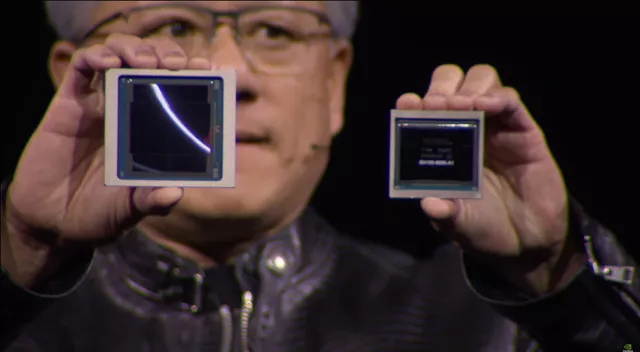

In un'epoca che ormai osserva con una certa indulgenza la legge di Moore (le GPU di Nvidia si sono fatte 1000 volte più potenti in appena otto anni), le imponenti iniezioni di capitale nelle IA sollecitano un'incessante spinta innovativa per conservare la superiorità competitiva. Tuttavia, malgrado i rivali restino sempre in agguato, Nvidia sembra proseguire senza particolari preoccupazioni la sua traiettoria ascendente, come dimostra l'ultimo annuncio riguardante Blackwell, la nuovissima linea di processori pensati per l’era dell’intelligenza artificiale generativa. L'annuncio, avvenuto in occasione della conferenza GTC a San Jose, rafforza ulteriormente la reputazione di Nvidia come fulcro per le imprese operanti nell'IA. La nuova gamma di processori inaugura infatti un'era caratterizzata da un avanzamento qualitativo e quantitativo notevole, col nuovo GPU Blackwell B200 e il "superchip" GB200, in arrivo entro l'anno.

A ciò si aggiunge l'introduzione del software NIM, che sta per Nvidia Inference Microservice, che si propone di facilitare l'adozione dell'IA fornendo ulteriori motivi per prediligere i chip Nvidia in un contesto competitivo sempre più serrato.

La trasformazione di Nvidia da semplice produttore di chip a fornitore di piattaforme integrate, seguendo le orme di colossi come Microsoft o Apple, consente alle aziende di sviluppare soluzioni software personalizzate. "Blackwell non è solo un chip ma una piattaforma completa", dichiara non a caso Huang, segnalando un cambiamento strategico con un focus rinnovato sul software come prodotto commerciale. "Il nostro prodotto vendibile finora erano le GPU; il software era complementare, volto a facilitarne l'utilizzo in vari contesti", ha dichiarato Manuvir Das, VP Enterprise di Nvidia. "Continuiamo su questa linea ma ciò che ha realmente subito un cambiamento è la nostra espansione nel settore del software commerciale".

Grazie a NIM, sarà più semplice eseguire applicazioni su qualsiasi GPU Nvidia, essendo capace di estendere le capacità operative anche ai modelli di GPU precedenti, offrendo così un valore aggiunto significativo. Oltre ovviamente al risparmio derivante dal non dover necessariamente rinnovare il parco delle proprie GPU. Ma nulla è lasciato al caso e questa strategia pare volta a far sì che i clienti che acquistano server basati su Nvidia si iscrivano a Nvidia Enterprise, programma nel quale una singola licenza costa 4.500 dollari per GPU all'anno.

Con l'introduzione dell'architettura Blackwell, Nvidia promette un salto prestazionale senza precedenti nel settore dell'intelligenza artificiale. Grazie ai suoi 208 miliardi di transistor, con 20 petaflop di potenza di calcolo rispetto ai 4 petaflop dell'H100 basato su architettura Hopper, il processore B200 permetterà lo sviluppo di modelli di IA più complessi e di maggiori dimensioni. Inoltre, un GB200 che combini due di queste GPU con un singolo CPU Grace, può offrire 30 volte la performance essendo anche molto più efficiente. "Riduce i costi e il consumo energetico fino a 25 volte" rispetto a un H100, afferma Nvidia. Il nuovo processore di Nvidia è anche meno assetato: addestrare un modello con 1,8 trilioni di parametri avrebbe precedentemente richiesto 8.000 GPU Hopper e 15 megawatt di potenza. Oggi, il CEO di Nvidia afferma che 2.000 GPU Blackwell possono farlo consumando solo quattro megawatt. Colossi come Amazon, Google, Microsoft e Oracle offriranno l’accesso al GB200 attraverso i loro servizi cloud. Il sistema GB200 verrà poi utilizzato da Amazon Web Services per creare un cluster di server dotato di 20.000 processori.

Nvidia non ha fornito il costo del nuovo B200 ma possiamo orientarci pensando che quello dell'H100 basato su Hopper varia tra i 25.000 e i 40.000 dollari per processore, con sistemi interi che costano fino a 200.000 dollari. Qualsiasi sarà il costo finale della nuova proposta di Nvidia, però, resta il fatto che sarà in grado di gestire modelli di IA fino a 27 trilioni di parametri, superando di gran lunga i 1,7 trilioni di parametri necessari ai modelli attuali come GPT-4. Poco importa che molte aziende non siano ancora riuscite a mettere mano sugli attuali H100: l'AGI sembra sempre più vicina e questo basterà al mercato.

ARRIVA BLACKWELL

In un'epoca che ormai osserva con una certa indulgenza la legge di Moore (le GPU di Nvidia si sono fatte 1000 volte più potenti in appena otto anni), le imponenti iniezioni di capitale nelle IA sollecitano un'incessante spinta innovativa per conservare la superiorità competitiva. Tuttavia, malgrado i rivali restino sempre in agguato, Nvidia sembra proseguire senza particolari preoccupazioni la sua traiettoria ascendente, come dimostra l'ultimo annuncio riguardante Blackwell, la nuovissima linea di processori pensati per l’era dell’intelligenza artificiale generativa. L'annuncio, avvenuto in occasione della conferenza GTC a San Jose, rafforza ulteriormente la reputazione di Nvidia come fulcro per le imprese operanti nell'IA. La nuova gamma di processori inaugura infatti un'era caratterizzata da un avanzamento qualitativo e quantitativo notevole, col nuovo GPU Blackwell B200 e il "superchip" GB200, in arrivo entro l'anno.

CHIP AS A SERVICE

A ciò si aggiunge l'introduzione del software NIM, che sta per Nvidia Inference Microservice, che si propone di facilitare l'adozione dell'IA fornendo ulteriori motivi per prediligere i chip Nvidia in un contesto competitivo sempre più serrato.

La trasformazione di Nvidia da semplice produttore di chip a fornitore di piattaforme integrate, seguendo le orme di colossi come Microsoft o Apple, consente alle aziende di sviluppare soluzioni software personalizzate. "Blackwell non è solo un chip ma una piattaforma completa", dichiara non a caso Huang, segnalando un cambiamento strategico con un focus rinnovato sul software come prodotto commerciale. "Il nostro prodotto vendibile finora erano le GPU; il software era complementare, volto a facilitarne l'utilizzo in vari contesti", ha dichiarato Manuvir Das, VP Enterprise di Nvidia. "Continuiamo su questa linea ma ciò che ha realmente subito un cambiamento è la nostra espansione nel settore del software commerciale".

Grazie a NIM, sarà più semplice eseguire applicazioni su qualsiasi GPU Nvidia, essendo capace di estendere le capacità operative anche ai modelli di GPU precedenti, offrendo così un valore aggiunto significativo. Oltre ovviamente al risparmio derivante dal non dover necessariamente rinnovare il parco delle proprie GPU. Ma nulla è lasciato al caso e questa strategia pare volta a far sì che i clienti che acquistano server basati su Nvidia si iscrivano a Nvidia Enterprise, programma nel quale una singola licenza costa 4.500 dollari per GPU all'anno.

DUE CUORI

Con l'introduzione dell'architettura Blackwell, Nvidia promette un salto prestazionale senza precedenti nel settore dell'intelligenza artificiale. Grazie ai suoi 208 miliardi di transistor, con 20 petaflop di potenza di calcolo rispetto ai 4 petaflop dell'H100 basato su architettura Hopper, il processore B200 permetterà lo sviluppo di modelli di IA più complessi e di maggiori dimensioni. Inoltre, un GB200 che combini due di queste GPU con un singolo CPU Grace, può offrire 30 volte la performance essendo anche molto più efficiente. "Riduce i costi e il consumo energetico fino a 25 volte" rispetto a un H100, afferma Nvidia. Il nuovo processore di Nvidia è anche meno assetato: addestrare un modello con 1,8 trilioni di parametri avrebbe precedentemente richiesto 8.000 GPU Hopper e 15 megawatt di potenza. Oggi, il CEO di Nvidia afferma che 2.000 GPU Blackwell possono farlo consumando solo quattro megawatt. Colossi come Amazon, Google, Microsoft e Oracle offriranno l’accesso al GB200 attraverso i loro servizi cloud. Il sistema GB200 verrà poi utilizzato da Amazon Web Services per creare un cluster di server dotato di 20.000 processori.

Nvidia non ha fornito il costo del nuovo B200 ma possiamo orientarci pensando che quello dell'H100 basato su Hopper varia tra i 25.000 e i 40.000 dollari per processore, con sistemi interi che costano fino a 200.000 dollari. Qualsiasi sarà il costo finale della nuova proposta di Nvidia, però, resta il fatto che sarà in grado di gestire modelli di IA fino a 27 trilioni di parametri, superando di gran lunga i 1,7 trilioni di parametri necessari ai modelli attuali come GPT-4. Poco importa che molte aziende non siano ancora riuscite a mettere mano sugli attuali H100: l'AGI sembra sempre più vicina e questo basterà al mercato.

Trending

RICEVI GRATIS LE NOTIZIE IN ANTEPRIMA

RICEVI GRATIS LE NOTIZIE IN ANTEPRIMA